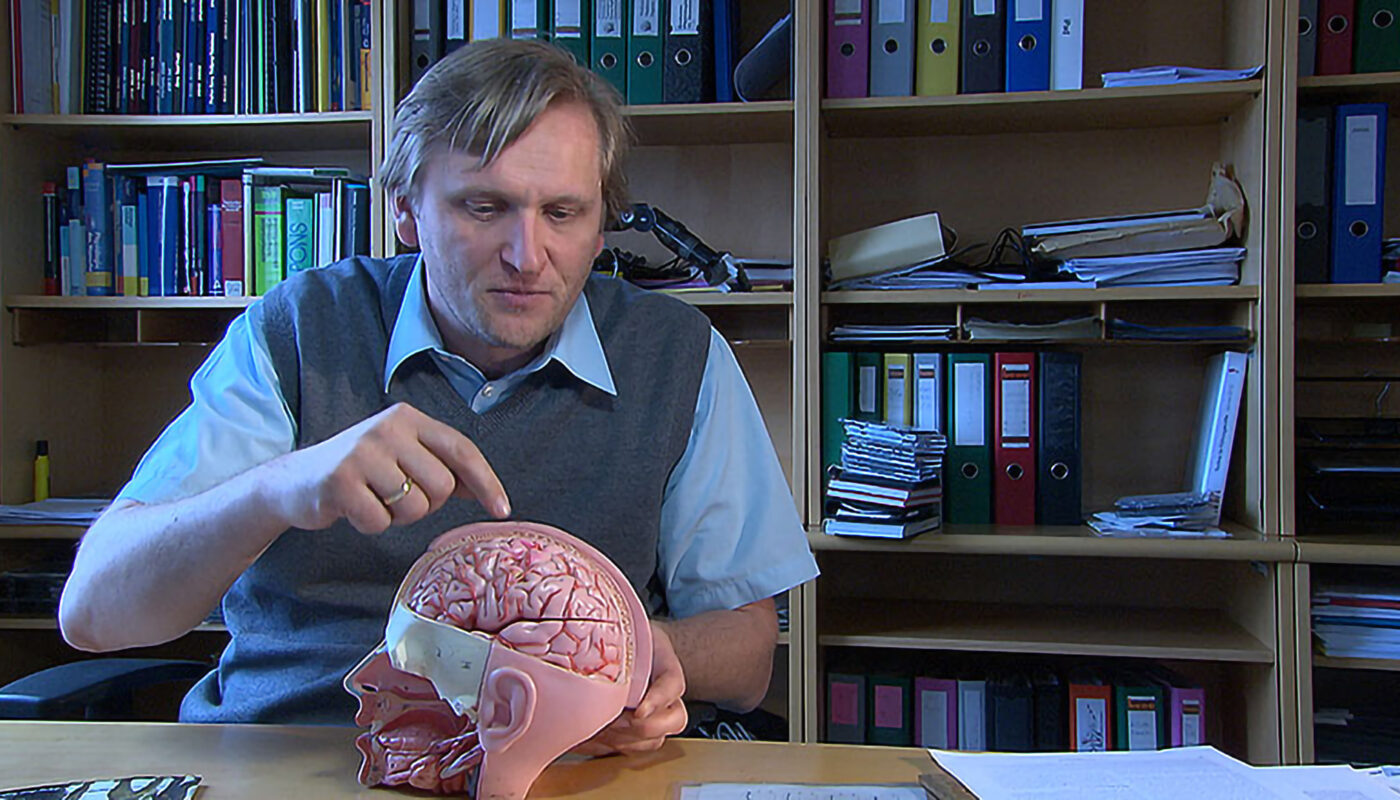

Gernot Müller Putz im Gespräch (2012)

• Gerätesteuerung nur mit Gedanken: faszinierende neue technische Möglichkeiten stellen Hilfen für gelähmte Menschen in Aussicht. Prof. Gernot Müller-Putz vom Institut für semantische Datenanalyse an der TU Graz im Gespräch.

Sie arbeiten mit Ihrem Team im Institut für Semantische Datenanalyse an Möglichkeiten, nur mit Hilfe von Gedanken Computer und Geräte zu steuern. Was geschieht dabei? Haben Sie den Schlüssel zum Gedankenlesen gefunden?

MÜLLER-PUTZ: Den Schlüssel zum Gedankenlesen haben wir nicht. Wir verwenden aber sehr wohl das Denken, um verschiedene Geräte und Anwendungen zu steuern, indem wir Denkmuster herausfinden. Das funktioniert im wesentlichen so, dass Patienten oder Benutzer durch verschiedene Gedanken Gehirnmuster erzeugen, die wir dann durch Messungen erkennen. Wenn man zum Beispiel weiß, dass der Benutzer entweder an eine Handbewegung denkt oder an eine Fußbewegung, dann kann man daraus ein Steuersignal erzeugen und damit eine Computeranwendung, zum Beispiel ein Schreibprogramm, steuern. Patienten mit schweren motorischen Beeinträchtigungen sollen dadurch wieder kommunizieren, schreiben, im Internet surfen oder ihre Umwelt steuern können.

Ein wesentliches Ziel ist also, Menschen mit Bewegungsbeeinträchtigungen zu helfen. Befragungen von hochgradig querschnittgelähmten Menschen brachten ja immer wieder zum Ausdruck, dass das Greifenkönnen für sie eines der wichtigsten Anliegen ist und ihre Lebensqualität auch entscheidend verbessern würde. Ist eine solche Technologie, dass ein Patient also nur mit Hilfe von Gedankenkraft wieder greifen kann, in Sicht?

MÜLLER-PUTZ: Ja, das Greifen ist ganz wichtig. Man macht so viele Dinge unbewusst mit den Händen, und wenn das plötzlich alles wegfällt, dann bricht eine Welt zusammen. Wenn man also für Patienten mit sehr hohen Querschnittlähmungen ein einfaches Greifen wiederherstellen könnte, dann würden diese Menschen viel von ihrer Eigenständigkeit zurückbekommen. Wie kann man das machen? Man kann es sich so vorstellen, dass man mit Hilfe der funktionellen Elektrostimulation, also durch Muskelstimulation, den gelähmten Arm ansteuert und ein einfaches Greifen erzeugt. Der Patient kann also durch die sogenannte Neuroprothetik seine Hand öffnen und die Finger wieder schließen, also etwas anfassen, und diese Neuroprothetik muss irgendwie angesteuert werden. Das könnte man mit einem Schalter machen, der am Körper angebracht ist. Wenn Patienten aber auch Schulter und Ellbogen nicht mehr bewegen können, dann gibt es nicht mehr viele Möglichkeiten, wie man ein solches Steuersignal erzeugen kann, und deshalb kommt unsere Arbeitsgruppe ins Spiel. Wir wollen das Denken an die Bewegung in eine tatsächliche Bewegung des gelähmten Arms umsetzen.

Ihr Team arbeitet auch an verschiedenen EU-Forschungsprojekten mit. Eines davon hat den Titel „BrainAble“. Dabei geht es um die Entwicklung einer möglichst komfortablen „Mensch-Computer-Schnittstelle“ mit dem Ziel, dass man allein durch die Gehirntätigkeit befähigt ist, bestimmte Handlungen vorzunehmen. Geht es dabei auch um medizinische Anwendungen?

MÜLLER-PUTZ: Ja, die EU-Projekte, an denen wir arbeiten, haben alle medizinische Zielsetzungen. Das, von dem ich vorhin gesprochen habe, fällt unter das EU-Projekt TOBI – Tools für Brain Computer Interaction. Im EU-Projekt „BrainAble“ geht es darum, beeinträchtigte Menschen mit einer Steuerung für ihre Umwelt auszustatten. Das heißt, dass diese Patienten wieder eine Kontrolle über ihre Umwelt bekommen, dass sie beispielsweise das Internet oder generell IT-Techniken benutzen können, also E-Mails schreiben, im Internet surfen, twittern, aber auch ihre Umgebung steuern. Diese Patienten können ja zum Beispiel nicht einfach hingehen und das Licht einschalten. Aber assistierende Technologien, die von einem „Brain Computer Interface“ angesteuert werden, können das machen. Das heißt, ich wähle beispielsweise den Befehl aus: „Licht einschalten“ oder: „Jalousie herunterfahren“, oder ich wähle einen bestimmten Film aus, den ich mir gerne anschauen möchte – in diese Richtung geht das „BrainAble“-Projekt.

Es gibt auch schwerkranke Menschen, die praktisch keinen Kontakt mehr zur Außenwelt haben, Stichwort „Wachkoma-Patienten“. Bei diesen Patienten gibt es ja immer wieder Fälle tragischer Fehldiagnosen. Man nimmt an, dass solche Menschen von ihrer Außenwelt gar nichts mehr mitbekommen, und stellt irgendwann doch fest, dass ein bestimmter Grad von Bewusstsein noch vorhanden ist. Sehen Sie technische Möglichkeiten, bessere Diagnosewerkzeuge für solche Wachkoma-Patienten herzustellen, die auch gezielt mit den Gehirnströmen arbeiten?

MÜLLER-PUTZ: Ja, es gibt ein Projekt mit dem Namen „Decoder“. Hier geht es genau darum, ein Diagnosetool zu schaffen, um eben festzustellen, ob Patienten noch Bewusstsein oder Restbewußtsein oder fallweise Bewusstsein haben oder ob sie definitiv kein Bewusstsein mehr haben und sich in einem vegetativen Zustand befinden. Dafür benötigt man dringend ein Diagnosetool.

Und was macht man, um Bewusstsein zweifelsfrei festzustellen oder auszuschließen?

MÜLLER-PUTZ: Man kann bestimmte Gehirnfunktionen mit ganz einfachen Experimenten überprüfen. Zum Beispiel kann man feststellen, ob ein Patient verschiedene Pieptöne unterscheiden kann. Wenn man weiß, dass das Hirn das kann, dann kann man den Schwierigkeitsgrad etwas erhöhen und zum Beispiel Sätze vorgeben, die entweder semantisch richtig oder semantisch falsch sind … Grundsätzlich startet man mit „passiven Paradigmen“, wo also der Patient nur zum Zuhören eingeladen wird, und dann gibt es noch die „aktiven Paradigmen“, wo man zum Beispiel sagt: „Bitte zählen Sie die Pieptöne, die von den normalen Pieptönen abweichen.“ Man kann mit Hilfe solcher Experimente feststellen, ob der Patient diese Anweisungen mitmacht oder auch nicht. Und wenn man sieht, dieser Patient, zu dem man so keinen offensichtlichen Zugang hat, hört die Anweisungen und macht mit, dann kann man feststellen, dass er eigentlich in diesem Moment Bewusstsein hat, es aber nicht nach außen transportieren kann. Die Analyse der Gehirnströme macht das sichtbar. Die Idee ist, ein ganz einfaches „Brain Computer Interface“ anzudocken, wodurch der Patient mental Antworten geben kann oder einen simulierten Tastendruck erzeugt, um zum Beispiel Ja oder Nein zu sagen. Das Ziel des „Decoder“-Projektes ist also eine ganz einfache, rudimentäre Kommunikation mit Patienten, die noch Bewusstsein haben. Man hat natürlich schon mit Hilfe der funktionellen Magnetresonanztomographie gezeigt, dass solche Patienten Anweisungen befolgen können. Aber ein Scanner ist ein sehr großer Apparat. Unser Projekt soll die Erkenntnisse aus der Magnetresonanztomographie in die Elektroenzephalographie überleiten, also in das Aufzeichnen der Gehirnströme, denn das dafür nötige Gerät kann man überallhin mitnehmen, wodurch man ganz einfach vor Ort, auch zu Hause arbeiten kann.

Welche medizinischen Möglichkeiten stehen denn mit dieser Technologie noch in Aussicht? Es gibt ja noch weitere EU-Projekte, an denen Sie arbeiten!

MÜLLER-PUTZ: Diese Projekte beschäftigen sich unter anderem mit der Schlaganfall-Rehabilitation, zum einen bei Schädigungen an der oberen Extremität, also der Hand und des Armes, zum anderen aber auch an der unteren Extremität. Hier geht es darum, einen Patienten während der Therapie zu beobachten. Wenn er seine betroffenen Extremitäten bewegen soll, sie aber nicht bewegen kann, läßt sich anhand der Analyse der Gehirnmuster feststellen: Jetzt hat der Patient versucht, den Arm zu bewegen oder die Hand zu bewegen. Diese Beobachtung wird dann an den Therapeuten und an den Patienten zurückgemeldet, nach dem Motto: Ja, das war gut, das ist der Weg, den Arm zu bewegen – auch wenn die Bewegung tatsächlich nicht stattgefunden hat. Man kann dann zum Beispiel ein robotisches Gerät oder eine Elektrostimulation verwenden, um den Arm entsprechend zu bewegen. Durch die Bewegung werden dann Signale von der Extremität an das Gehirn geliefert, und das Gehirn versucht dann, irgend etwas mit diesen Signalen zu machen. Der Ansatz geht also dahin, dass das Gehirn mit Hilfe des „Brain Computer Interface“ und durch die Rückmeldung der Bewegung schneller lernt, die Extremität wieder zu bewegen.

Wo liegen denn nach Ihrer heutigen Einschätzung die Grenzen dieser Technologie, dass man gedankliche Tätigkeiten von außen analysiert und dann in Nutzanwendungen umsetzt? Gibt es da Grenzen?

MÜLLER-PUTZ: Ja, da gibt es klarerweise Grenzen. Ein Signal, das vom Gehirn kommt, könnte man direkt im Gehirn sehr gut messen, aber es gibt ja verschiedene Schichten, Gehirnhäute, Knochen, die Haut, das alles dämpft das Signal sehr stark ab, und was wir am Kopf messen, das hat nur noch Millionstel Volt, das Signal ist also sehr, sehr klein. Um es zu messen, braucht man bestimmte Apparaturen, sogenannte Messverstärker, die diese Spannungen so weit verstärken, dass man sie überhaupt in einem Computer verarbeiten kann. Außerdem haben die Elektroden, die wir am Schädel plazieren, einen Durchmesser von etwa acht Millimetern, und darunter sind Millionen von Nervenzellen, die alle ihre Aktivität haben. Diese Nervenaktivität breitet sich kugelförmig aus, und durch den Abstand vom Kortex bis zur Elektrode ist es nur noch möglich, am Schädel die Summe der Nervenaktivität zu messen. Das heißt, es sind von der Messmethode her bestimmte Grenzen gesetzt. Ich kann mit meinen Elektroden nur ganz grob detektieren, ob es sich zum Beispiel um eine Handbewegung oder um eine Ellbogenbewegung handelt. Fingerbewegungen klar zu messen, zum Beispiel die Bewegung nur des kleinen Fingers, wird mir nicht mehr möglich sein. Und um das weiterzuspinnen: Wenn Sie an eine Katze oder an ein Auto denken, kann ich das unmöglich messen, denn es gibt kein Katzenzentrum oder Autozentrum im Gehirn. Die Möglichkeit des Gedankenlesens, die man durch diese Technologie allgemein manchmal befürchtet, sehe ich, wenn überhaupt, in sehr, sehr weiter Ferne.

Herzlichen Dank für das Gespräch!

Durch Klick auf dieses Video willigen Sie der Datenverarbeitung und -übertragung durch bzw. an YouTube/Google zu. Details in der Datenschutzerklärung.